超越 SoC 范式:下一代移动 AI 芯片将走向何方?

围绕 ChatGPT 的热度已经开启了生成 AI 的新时代。这种新鲜的技术旋风正在彻底改变一切,从基于云的人工智能服务器一直到智能手机的边缘计算。

鉴于生成式 AI 具有培育新应用和提高用户生产力的巨大潜力,智能手机已成为 AI 技术的重要工具也就不足为奇了。尽管终端设备的计算能力无法与云相提并论,但它具有降低总体计算成本和保护用户隐私的双重好处。这就是智能手机 OEM 几年前开始使用 AI 芯片探索和实现新功能的主要原因。

不过,近期 Oppo 关闭其芯片设计公司哲库的决定,让智能手机 OEM 厂商自研芯片的未来产生了一些疑虑,智能手机 AI 芯片市场成为焦点。

急需加速 AI 芯片迭代

业界目前在终端设备上运行生成式 AI 模型的方法包括两个方面:软件侧重于减小模型的大小以减轻芯片的负担和能耗,而硬件侧则致力于提高计算能力和优化通过流程收缩和架构升级来减少能源使用。

IC 设计公司,如高通及其 Snapdragon8 Gen.2,现在正加紧开发能够运行这些生成式 AI 基础模型的 SoC 产品。

不过,这是棘手的部分:模型以远远超过 SoC 开发周期的速度不断发展——像 GPT 这样的更新每六个月进行一次。硬件迭代和新的 AI 模型进步之间的差距可能只会越来越大,使得计算需求的快速扩展成为硬件解决方案提供商需要解决的主要痛点。

顶级 OEM 开创了附加 AI 加速器

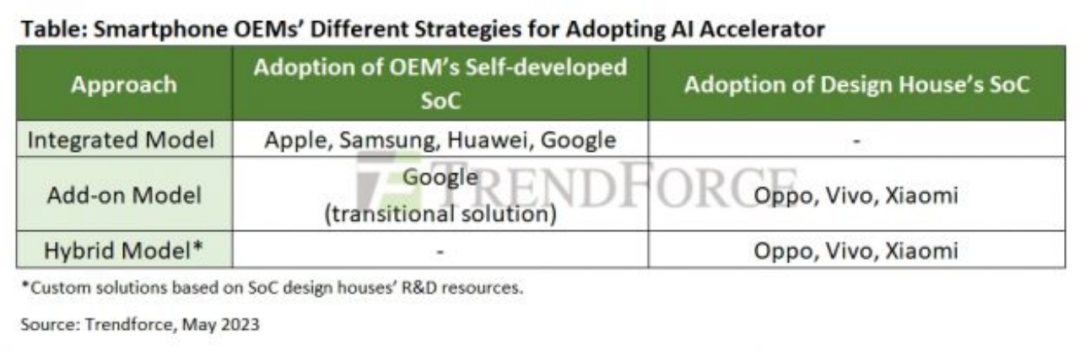

很明显,在这场 AI 计算能力的竞赛中,过去对 SoC 的依赖正在受到挑战。顶级智能手机 OEM 不再仅仅依赖 SoC 供应商的标准产品。相反,他们正在积极采用 AI 加速器芯片来填补计算空白。

集成和附加 AI 加速器的方法最早见于 2017 年:

集成:该策略的代表是华为的 Kirin970 和 Apple 的 A11 Bionic,它们在 SoC 中集成了 AI 引擎。

Add-on:最初由 Google Pixel 2 实现,它使用定制的 Pixel Visual Core 芯片和 Snapdragon 835。直到 2021 年的 Pixel 6 系列引入了 Google 自研的 Tensor SoC,才直接集成了加速单元进入张量。

显然,具备自研 SoC+能力的 OEM 厂商,通常会在设计阶段就将其模型嵌入到 AI 加速器中。这种硬件-软件协同作用为特定的 AI 场景提供所需的计算能力。

史诗般的战斗:崛起的新战略模式

对于没有自主研发能力的 OEM 厂商来说,SoC 开发的高昂成本让他们不得不依赖芯片厂商的 SoC 迭代。然而,他们还在供应链中应用新战略以跟上快速变化的步伐。

这是有趣的部分,品牌正在利用更简单的专用芯片来推动支持 AI 的应用程序,使像 ISP(图像信号处理器)这样的独立 IC 成为摄影和显示新功能的关键。与此同时,我们也看到了生产力工具领域的潜在进步,从语音助手到照片编辑人们认真考虑实施小型 ASIC 来满足计算需求。

从小米与 Altek 的合作以及 Vivo 与 Novatek 共同开发 ISP 来看,ASIC 开发的前景一片光明,为小型 IC 设计和 IP 服务提供商打开了机会。

为应对这一趋势,SoC 领导者联发科正在采用开放式 5G 架构战略,通过许可和定制服务扩展市场。不过,有猜测称,OEM 可能会用自主开发的 IP 取代联发科的标准 IP,以实现更深层次的产品差异化。

如此看来,AI 芯片之争显然还在继续,智能手机 AI 芯片产品加速迭代并无胜算。

人工智能服务器的高成本和复杂性不可避免地限制了其开发仅限于大型制造商。HPE 和戴尔这两家领先的公司采取了不同的策略进入市场:

HPE 不断加强与谷歌的合作,计划到 2022 年将所有产品转化为服务形式。它还于 2023 年 1 月收购了初创公司 Pachyderm,推出基于云的超级计算服务,让训练和开发大型模型变得更加容易。

2023 年 3 月,戴尔推出了最新的 PowerEdge 系列服务器,提供配备 NVIDIA H100 或 A100 Tensor Core GPU 和 NVIDIA AI Enterprise 的选项。他们采用第四代英特尔至强可扩展处理器,引入戴尔软件 Smart Flow,满足数据中心、大型公有云、人工智能、边缘计算等不同需求。

随着 AIGC 应用程序市场的蓬勃发展,我们似乎离以完全虚拟化内容为中心的未来元宇宙又近了一步。然而,硬件基础设施是否能跟上激增的需求仍不明朗。这种持久的挑战将继续考验云服务器制造商平衡成本和性能的能力。

考虑到芯片开发所需的大量资源和智能手机市场的饱和,保持芯片相关战略为 OEM 增加了一层不确定性。随着 Oppo 停止芯片研发,其他品牌如 vivo 和小米可能会重新考虑他们的游戏计划,因此,未来值得密切关注。

评论