从NN神经网络理解隐空间

在2023 年1 月刊连载中,我们曾经说明在AIGC领域里,最近几个很红的图像模型,例如DALLE、Imagen 和Midjourney 等, 它们都是基于一种机制:扩散(Diffusion)。经由模型训练,操作隐空间(Latent space) 的向量,加上随机输入中合成新的数据,呈现出令人惊奇的创作,推动了AI 组合的创新或创作。这意味着,关于AI 的生成或创作,大多会涉及隐空间的操作。

现在先从一个基本问题出发,这个问题是:为什么AI会创作呢?由于当今的AI是基于ML( 机器学习),它会向人类学习。继续探索下去,它向人类学习什么呢?学习人类的做事和创物的经验直觉。经验直觉的逻辑是不清晰的,无法经由编程来写成代码。那我们该如何把人类的直觉智慧弄进机器(AI) 呢?

答案是:从人类的作品( 如绘画、音乐、文学作品、食谱、游戏、对话、网络文章) 中学习作品的形式、风格、情绪等。这些作品被放到网络上,皆成为大数据(Big Data)。于是,我们就拿这些大数据来给AI 学习,谓之训练(Training)。

AI 从人类作品中学习到人类专家( 创作者) 的招式(Patterns) 和风格(Style)。如同金庸武侠小说中的杨过、小龙女向大侠们学习了许多武功招式。经年累月,杨过和小龙女学而时习之,逐渐地在内心深处沉淀出招式背后的精华神韵,谓之无招秘境。

一样地,AI 经过几十天学习大量作品的创作招式和风格,逐渐地在AI 模型内部的秘境中沉淀出招式背后的精华神韵,这个AI 中的无招秘境,谓之隐藏空间(Latent Space),又简称隐空间。

武侠中说:无中生有,从无招中生出千变万化,无招胜有招。一样地,AI 也能从其无招秘境中的精华神韵,生出千变万化的新招式,也就是新作品、新内容(Content)。这种新创作新内容,就谓之AIGC(AI Generated Content)。

除了上述的AI 创作力来自隐空间之外,隐空间也将会是管理大量繁杂模型的利器。例如,可以预测到了2030年之际,AI 模型将更为百花齐放,繁杂多样,就会导致难以管理,使得管理成本急速升高。

就如同20 世纪八九十年代,经济生产全球化,码头上货物形形色色,繁杂多样,非常难管理,导致管理成本急速升高。于是集装箱(Container) 这个角色就应运而生,大货轮也出来了,陆地上拖车业也大发利市了。同样地,到了2030 年,AI 模型的集装箱角色就很可能会出来。

我认为,AI 的隐空间即将成为AI 的集装箱。而且在未来数年内,凡是力求掌握潜藏空间,致力于开发控制软件系统,来有效管理AI 货柜( 即潜藏空间) 者,将成为AIGC 时代的大赢家。

2 从NN模型深刻理解隐空间

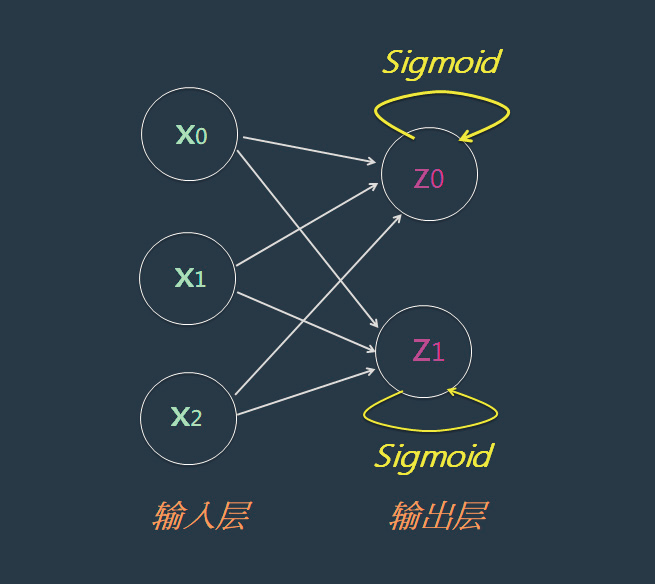

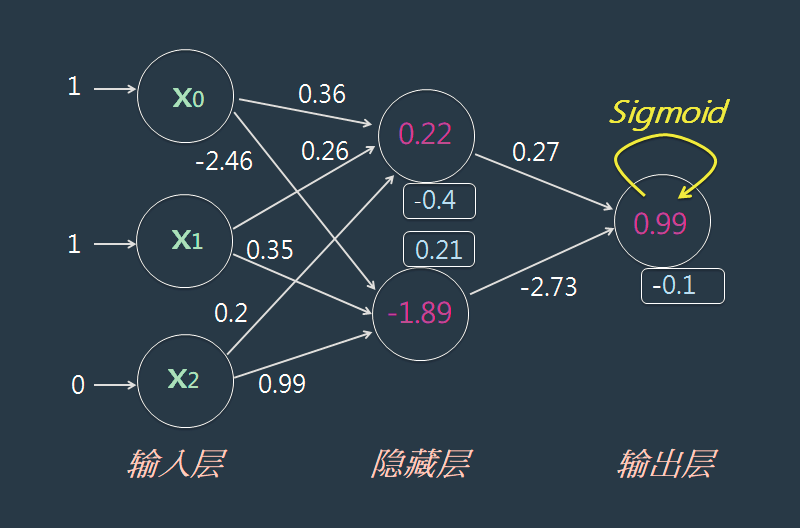

首先从最简易的单层NN(Neural network) 模型出发。这种简单模型只含有一层权重(Weight),兹以图1 这样的NN 图形为例。

图1

这个模型从X 空间对映到Z 空间。其含有两层(Layer) 神经元:左边的X 神经元是输入(Input) 层,而右边的Z 神经元,是输出(Output) 层。然而只有一层权重,所以通称为:单层NN 模型。接着,就可以继续扩大为两层NN 模型,如图2 所示。

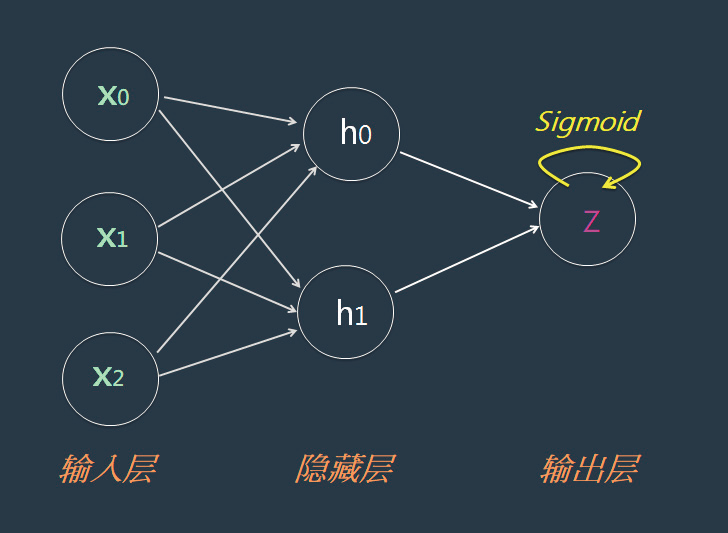

图2

这个NN模型里包含两层权重,所以称为:两层NN模型。这个中间层,又通称为:隐藏(Hidden) 层。它就是构成隐空间的核心机制。

3 观摩:以求职AI为例

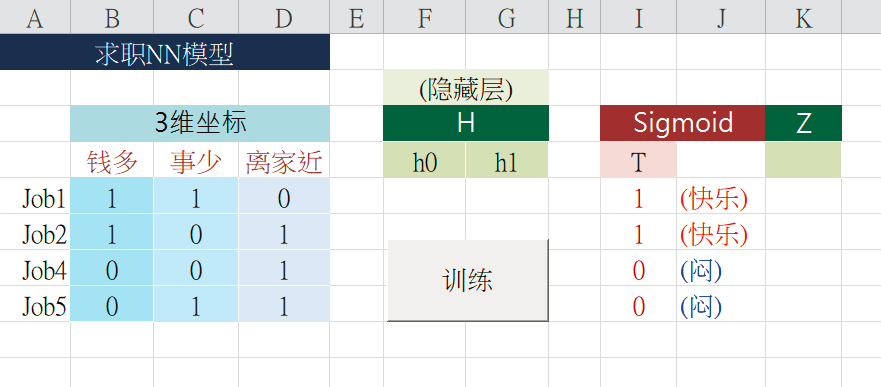

大家常常听说求职法则是:钱多、事少、离家近。我们如何把这个简单法则纳入NN 模型里,让它就学会这项法则呢。此时,人们透过T 值来表达他( 她) 心中的规则。

例如有人的求职法则是:“钱多”比“事少”更重要,“事少”比“离家近”更重要。当然,有人比较在意“钱多”,也有人认为“离家近”更重要。人人心中的规则可能各不相同,各自可修改这表格里的数据,表达自己特别的规则,如表1。

表1 三种条件的关联性

从这些数据可以看出来,这位人士心中的偏好是:“钱多”比“事少”更重要,“事少”比“离家近”更重要。只要给NN 模型一些训练,它就能认知到这位人士心中的规则了。虽然它听不懂人类的语言,也不需要写Python语言告诉它;只需要提供数据给它学习就可以了。

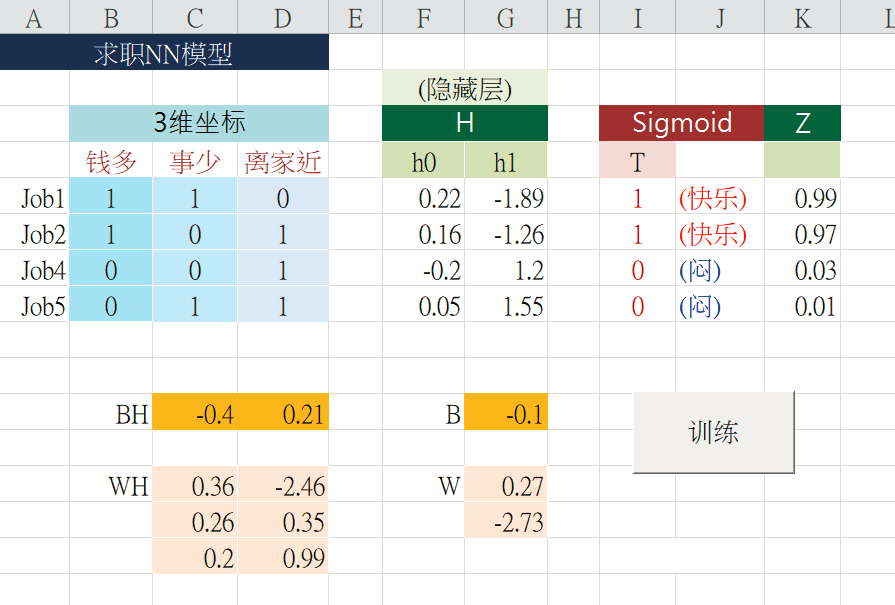

这个NN模型里的隐藏层,并没有使用Sigmoid()激活函数。一样地,只要按下这个< 两层一起学习>按钮,ML就会寻找出隐藏层的权重WH和BH,同时也寻找出输出层的权重W和B如表2。

表2 输出权重训练逻辑示意

然后将输入层X空间,对映到隐藏层H空间,再对映到输出层的Z空间。于是得出H和Z预测值。例如,将X=[1, 1, 0] 经由两层权重的计算流程如图3所示。

图3

最后计算出Z 值为:0.99。这就是典型的两层NN模型了。在训练的过程中,每一回合都会修正输出层的权重,也会修正隐藏层的权重。所以这两层权重是同步成长的。

4 多层的NN模型

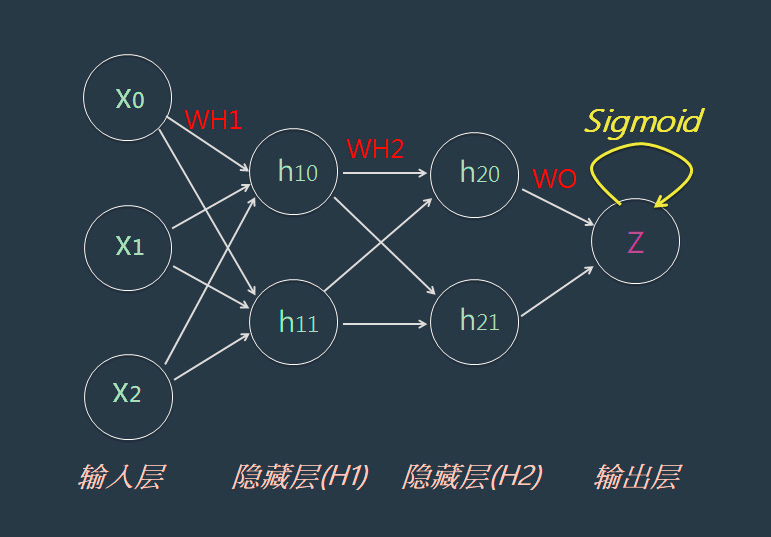

刚才的范例是两层NN 模型,它只含有一个隐藏层(Hidden Layer)。有些情境下,常常1 个NN 模型里,需要含有更多个隐藏层,这种模型就通称< 多层NN 模型>,或称为< 深度NN 模型>。

例如,可以继续扩大上述的NN 模型,让它含有两隐藏层,兹以NN 图形表示如图4 所示。

图4

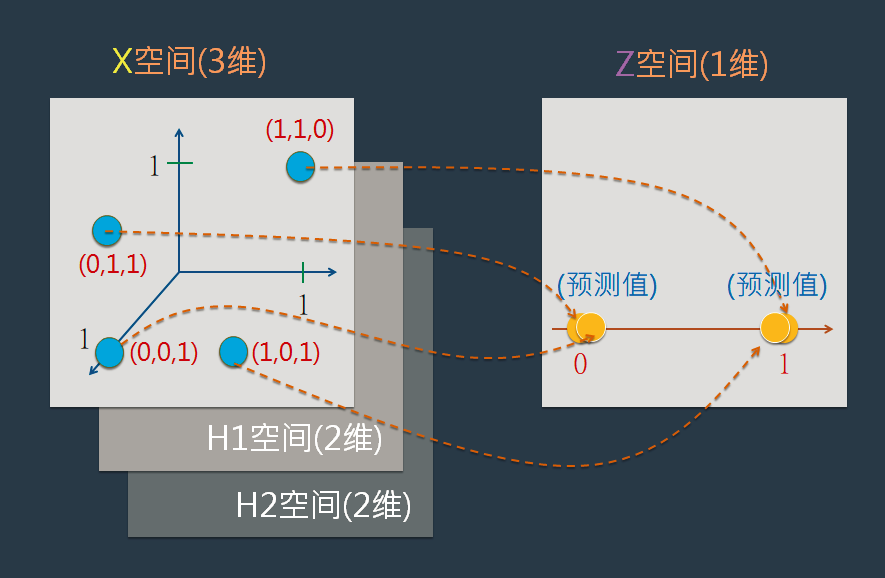

在训练及预测过程中,将输入层X空间,对映到隐藏层H1空间,再对映到隐藏层H2空间,再对映到输出层的Z空间。在隐藏层H1和H2里, 仍然使用X *W+B=Y 公式来表达其对映关系;而在输出层则使用X*W+B=Y 和 Sigmoid(Y) =Z公式来表达其对映关系。并计算出在Z空间里的预测值,如图5。

图5

此外,在许多情境里,常常需要建立更多个隐藏层,例如著名的ResNet 模型就多达数十个隐藏层,也是常见的多层深度NN 模型。而基于这种模型的机器学习,就通称为:深度学习(Deep Learning)。

5 结束语

以上介绍过了隐藏层(Hidden Layer) 的观念,位于这隐藏层的空间,就简称为:H 空间。其正式名称是:隐空间(Latent Space)。例如,在两层NN 模型里,其中的隐藏层(H 空间) 就是:隐空间。兹再复习一下,隐空间相当于金庸小说里武林大侠的< 无招> 境界。唯有高度掌握< 无招> 才能解释千变万化的招术。君不见,在AIGC领域里,AE、GAN和Diffusion等新潮技术,都是潜藏空间威力的表现。

(本文来源于《电子产品世界》杂志2023年3月期)

评论