上万颗英伟达芯片 + 微软数亿美元投资,带你揭秘 ChatGPT 背后的超级计算机

北京时间 3 月 14 日消息,人工智能聊天机器人 ChatGPT 一经推出便火爆全球,但外界可能不知道,ChatGPT 之所以能够如此智能,背后依托的是微软公司为它打造的一台昂贵的超级计算机。

本文引用地址:http://www.amcfsurvey.com/article/202303/444380.htm

微软超级计算机使用了上万颗英伟达 GPU

2019 年,当微软向 ChatGPT 开发商 OpenAI 投资 10 亿美元时,它同意为这家人工智能研究创业公司打造一台庞大的尖端超级计算机。唯一的问题是:微软没有 OpenAI 需要的那样的东西,也无法完全确定它能在 Azure 云服务中构建这么大的东西而不会破坏它。

当时,OpenAI 正试图训练一套规模越来越大的人工智能程序,也就是“模型”,后者正在吸收越来越大的数据量,学习越来越多的参数。这些参数是人工智能系统通过训练和再训练得出的变量。这意味着,OpenAI 需要在很长一段时间内使用强大的云计算服务。

上万颗芯片、数亿投资

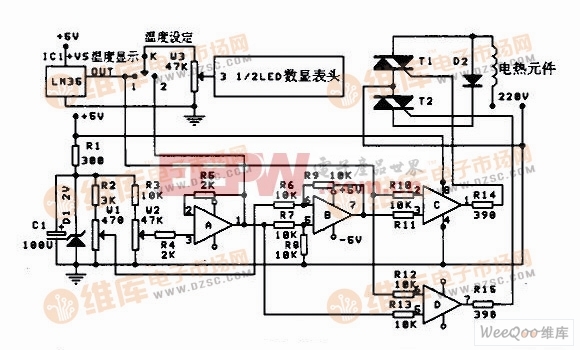

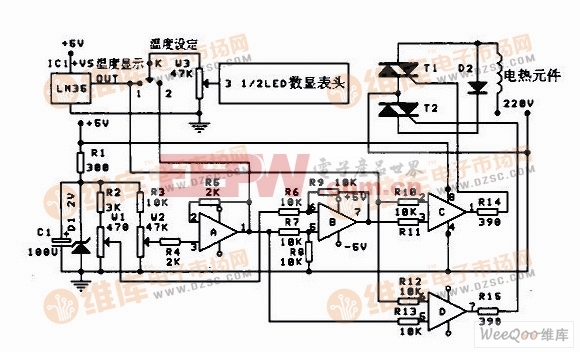

为了克服这一挑战,微软不得不想办法将数万颗英伟达 A100 图形芯片 (训练人工智能模型的主力) 组合在一起,并改变服务器在机架上的位置以防止断电。微软负责云计算和人工智能的执行副总裁斯科特・格思里 (Scott Guthrie) 不愿透露该项目的具体成本,但表示“可能不止”几亿美元。

“我们构建了一个可以在超大规模范围内运行并且可靠的系统架构。这就是 ChatGPT 成为可能的原因,”微软 Azure 人工智能基础设施总经理尼迪・查普尔 (Nidhi Chappell) 表示,“它是从中得出的一个模型,未来还会有很多很多其他的模型。”

ChatGPT 靠的是超级计算机训练

这项技术帮助 OpenAI 发布了 ChatGPT,后者在去年 11 月发布几天后就吸引了 100 多万用户,现在正被纳入其他公司的商业模式,从亿万富翁对冲基金创始人肯・格里芬 (Ken Griffin) 运营的公司,到外卖公司 Instacart。随着 ChatGPT 等生成式人工智能工具越来越受到企业和消费者的兴趣,微软、亚马逊公司和谷歌等云服务提供商将面临更大的压力,需要确保他们的数据中心能够提供所需的巨大计算能力。

现在,微软使用它为 OpenAI 构建的同一套资源来训练和运行自己的大型人工智能模型,包括上个月推出的新必应搜索机器人。微软还向其他客户销售该系统。作为微软与 OpenAI 扩大合作协议,追加 100 亿美元投资的一部分,该软件巨头已经在研究下一代人工智能超级计算机。

“我们不想把它打造成定制产品,它一开始是一个定制产品,但我们总是想办法把它打造成通用型产品,这样任何想训练大型语言模型的人都可以利用同样的改进,”格思里在一次采访中表示,“这真的能够帮助我们成为使用更广泛的人工智能云。”

训练一个庞大的人工智能模型需要在一个地方拥有大量相互连接的图形处理单元,就像微软组装的人工智能超级计算机一样。一旦模型投入使用,回答用户提出的所有查询 —— 称之为推理 —— 需要稍微不同的设置。微软还部署了用于推理的图形芯片,但这些成千上万个处理器在地理上分散在公司的 60 多个数据中心区域。微软周一在一篇博客文章中表示,现在该公司正在为人工智能工作负载添加最新的英伟达图形芯片 H100,以及最新版本的英伟达 Infiniband 网络技术,以更快地共享数据。

微软 Azure 云服务

目前,新必应搜索仍处于预览阶段。微软正在从等待名单中逐渐增加更多用户。格思里的团队每天与大约 24 员工举行会议,后者被称之为“后勤维修人员”,这一称呼原指一群在比赛中调整赛车的机械师。该小组的工作是弄明白如何让更强的计算能力快速上线,以及解决突然出现的问题。

“这很像是一种碰头会,就像是,‘嘿,任何人都有好主意,让我们今天把它放在桌面上讨论它,弄清楚好吧,我们可以在这里节省几分钟吗? 我们可以节省几个小时吗? 几天?’”格思里表示。

小错会酿成大祸

云服务依赖的是成千上万个不同的部件和物品,包括服务器的各个部件、管道、建筑物的混凝土、不同的金属和矿物,任何一个部件的推迟或供应不足,无论多么微小,都可能导致功亏一篑。最近,维修人员不得不处理电缆托盘的短缺问题。电缆托盘是一种篮子状的精巧装置,用来固定从机器上脱落的电缆。因此,他们设计了一种新的电缆托盘,使得微软可以自己制造,也可以找地方购买。格思里说,他们还在研究如何尽可能多地压缩世界各地现有数据中心的服务器,这样他们就不必等待新的大楼了。

当 OpenAI 或微软训练一个大型 AI 模型时,这些工作是一次性完成的。它被分配到所有的 GPU 上,某些时候各个单元需要相互交流来分享它们所做的工作。对于人工智能超级计算机,微软必须确保处理所有芯片之间通信的网络设备能够处理这种负载,并且必须开发出能够充分利用 GPU 和网络设备的软件。该公司现在推出了一款软件,可以训练具有数十万亿个参数的模型。

由于所有机器都是同时启动的,微软不得不考虑它们的放置位置和电源的位置。格思里说,否则,你最终会得到数据中心版本的结果,就像你在厨房里同时打开微波炉、烤面包机和吸尘器一样。

新一代超级计算机

微软 Azure 全球基础设施总监阿利斯泰尔・斯皮尔斯 (Alistair Speirs) 表示,该公司还必须确保能够为所有这些机器和芯片降温,并在较冷的气候条件下使用蒸发、室外空气,在炎热的气候条件下使用高科技沼泽冷却器。

格思里称,微软将继续开发定制服务器和芯片设计,并想办法优化供应链,以尽可能地提高速度、效率和节省成本。

“现在让世界惊叹的模型是建立在我们几年前开始建造的超级计算机上的。新的模型将建立在我们正在训练的新型超级计算机上,这台计算机更大,也更精密。”

评论