一种改进的可迁移深度学习模型*

摘 要:本文设计了一种改进的可迁移深度学习模型。该模型能够在离开可靠的训练环境(其中存在标签)并被置于纯粹的无标签数据的领域时,输出依然可以持续得到改善,这种训练方式可以降低对监督学习的依赖程度。

本文引用地址:http://www.amcfsurvey.com/article/202210/439590.htm*基金项目:湖南省教育厅科学研究课题“基于深度学习的智能无人机目标检测算法研究”(20C0105);

湖南省自然科学基金项目《基于高光谱特征信息融合的油菜籽品质参数反演与建模》(2021JJ60093);

校级培育项目“基于深度学习的目标检测算法研究”(22mypy15)

1 引言

随着深度学习的发展,深度卷积神经网络在图像识别上取得了很大突破 , 基于深度学习的图像识别方法避免了传统图像处理时最费时费力的特征提取部分,设计者只需要关注网络结构的设计,网络自动提取的特征越好,图像分类的准确率就越高。然而,上述分类模型的训练都需要带大量标签图像样本作为训练集,模型的性能严重依赖标签图像数据集的质量和规模,人工标签大量图像数据集的成本高 [1];面对互联网上出现的海量图像,图像标签的难度大大增加。为了提高数据分析的精度,深度学习技术的应用需要大量计算,由于模型结构越来越复杂,计算量成指数增长 [2],如何优化深度学习的神经网络模型是需要着重解决的问题。

2 基于弱监督的可迁移深度学习模型设计

与控制算法类似,有监督的深度学习算法 [3] 通过一个目标函数利用反馈。这个目标函数的输出作为输入(或“控制信号”)给反向传播进行自我修正。我们解决的主要问题是为深度学习算法找到一种方法,当它进入可靠的训练环境(其中存在标签),遇到纯粹的无标签数据的区域时,还能继续改善其输出。在这种环境中,机器必须减少对监督的依赖。因此我们设计了一种基于弱监督的可迁移学习模型。此模型是将一个预先训练好的模型用于另一个学习任务的过程(可能是在一个不同的、 不相关的区域)。这样在一个新的数据集上完全训练一个模型所需的计算时间和数据就会大大减少。预训练网络中的多个低层可以重新应用于另一个数据集,在那里它们可以重新得到训练。在重新训练的过程中,预训练模型的最后一层可以针对新的数据集进行微调。

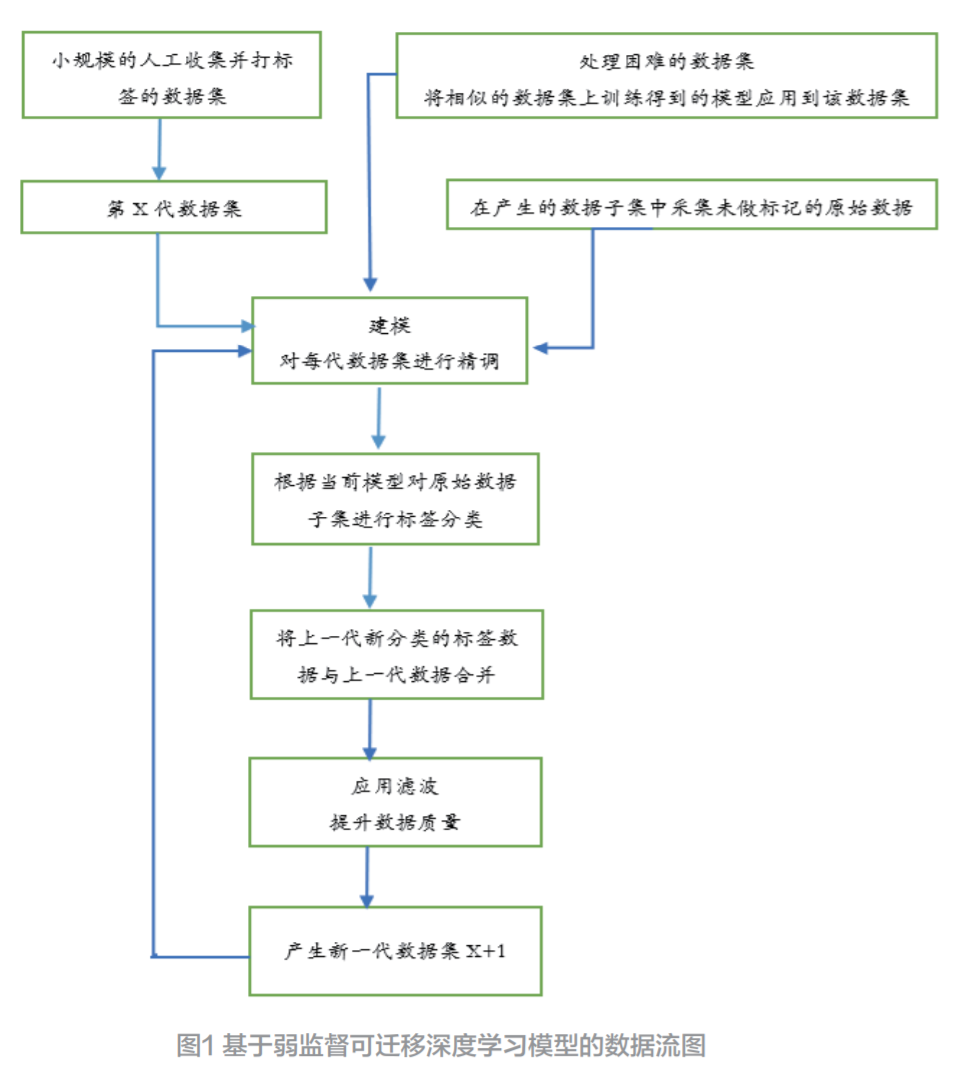

基于弱监督的可迁移学习模型的核心在于数据的导入和在神经网络中的循环方法。收集高质量和足够大的真实世界数据集来进行训练,具有挑战性并且高耗时。本学习模型通过要求一个相对较小的数据集来减轻这一负担,并以有效的方式使用该数据集来改进模型。基于弱监督可迁移深度学习模型的数据流图如图 1 所示。

对于复杂的数据集或有相似数据的数据集,基于弱监督的可迁移学习是一种初始化神经网络的有效方法,并使其有更大的机会获得更高的初始精度。初始生成的第 0 代数据集可以用小规模的数据点组成,这些数据点会被标注标签。由机器读取原始的、未标记的数据被分割成适当大小的可用处理模块,以满足可用的处理能力。然后将相似的每一组数据集都假定为有效的数据,分批送入神经网络。直观地说,原始的、无标签的数据由神经网络处理,用来确定每个数据点的标签。一旦这个新数据被标记,符合预定义标签的数据点就会与第 0 代数据相结合。然后,模型在新一代数据集上进行训练。这种数据融合对于模型的整体改进能力至关重要,测试产生的结果优于不加区分地处理所有未标注的数据。一旦创建了新一代的数据集,它就会被流回,用更大、更准确、更强大的标签数据集合重新调整模型。这个过程将重复进行,使模型得到改善,使得数据集得到增长。可迁移学习模型使用一个 CNN(卷积神经网络),这个 CNN 很简单:它由两个卷积层组成,每个卷积层都被重新激活。卷积层之后是一个 2×2 的最大池子层,反过来又反馈到一个全连接的、重新激活的层,然后分配一个 softmax 分类器。

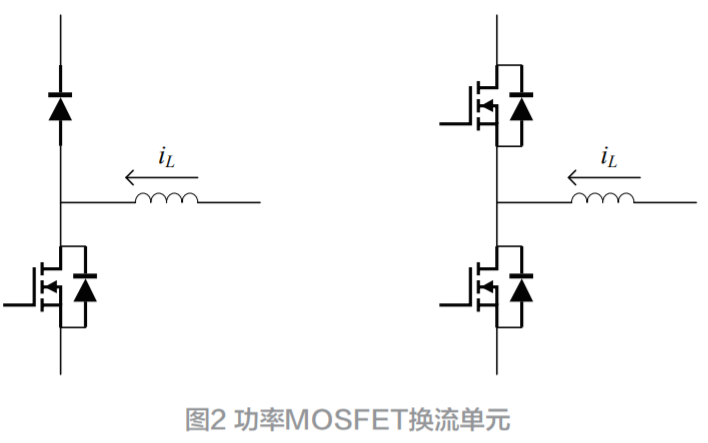

为了提高代码的速度和避免用可能的错误预测来稀释训练集,模型预测每批数据的标签,并在由第 0 代数据和新预测的数据合成的训练集中进行训练。附加的预测被存储在一个先进先出(FIFO)的队列式数据结构中。这样一来,模型对以前样本的记忆和训练,在新的批次出现之前至少会停留几个迭代。同时,预置的第 0 代数据仍然是永久性的,每次迭代代码都会将第 0 代和队列的内容一起进行训练。学习循环的另一个关键点是其不确定性的样本提取。在 FIFO 队列中预测的上一批训练数据追加到第 0 代之前,代码会检查每个样本的前两个标签的概率。如果一个样本的前两个标签概率相同或在一定范围内,那么在追加到 0 代之前,该样本将从训练集中提取出来。在这些情况下,附加的批次较小;提取后留下的空白没有被新的数据重新填补。因此,该模型避免了在不确定的预测上进行训练。这已被证明可以提高平均和最大的训练精度。基于弱监督的可迁移深度学习的算法如图 2 所示。

图2 基于弱监督的可迁移深度学习的算法

3 实验测试

MNIST 数据集是由 LeCun 等人开发的,用于评估手写数字分类问题的机器学习模型 [4]。该数据集是由美国国家标准与技术研究所(NIST)提供的一些扫描文件数据集构建的。数字的图像取自各种扫描文件,尺寸标准化并居中。该数据集已被研究人员广泛使用,因此可以对性能进行明确的衡量。这使得它成为评估模型的优秀数据集,使开发者能够专注于机器学习 [5]。数据集中每张图片是一个 28×28 像素的正方形。一个标准的分割数据集被用来评估和比较模型,其中 10 000 张图片被用来训练一个模型,另一组 5 000 张图片被用来测试。

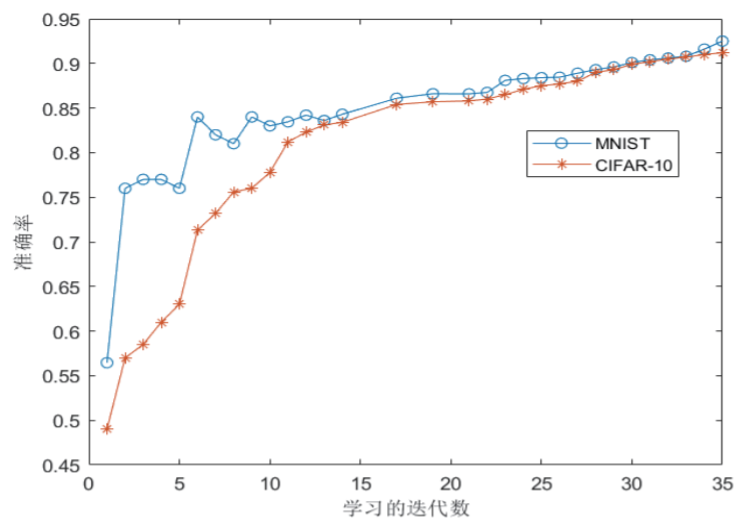

图3 载入MNIST数据集的样本图像

基于弱监督的可迁移学习模型测试从加载 MNIST 数据集开始。数据被分流到两个不同的类别:小于 5 的数字(L5)和大于或等于 5 的数字(G5)。L5 数据集用于预训练模型的权重;然后这些权重将被转移到模型上,该模型将不断学习如何标记 G5 数字。在转移了基于 L5 的权重后,代码首次将模型引入一小批 G5 数据中。将这批初始数据的规模定在 200 个左右,这是让模型对 G5 数字有必要的认识和理解的最小数量。该模型在这些数字的原始、正确的标签上进行训练。这个由 300 个 样本组成的原始数据集连同其标签被称为第 0 代。这就是持续学习的开始。一旦模型对数据集有了一些了解,代码就会进入一个循环,其中模型会处理一批又一批原始的、没有标签的数据。模型预测每批数据的标签,并在由第 0 代样本和新猜测的样本组成的联合训练集中进行训练。学习循环的下一次迭代将下一批 G5 数据追加到这个训练集上。一个小的初始数据集可以在其整个运行过程中进行训练。迄今为止改进最大的迁移学习方法使用了 35 代,初始 0 代大小为 100 张图像,随后几代的数据子集为 400 张图像。同时将此算法在 CIFAR-10 数据集上进行训练,图 4 显示在两个数据集上训练的准确率。

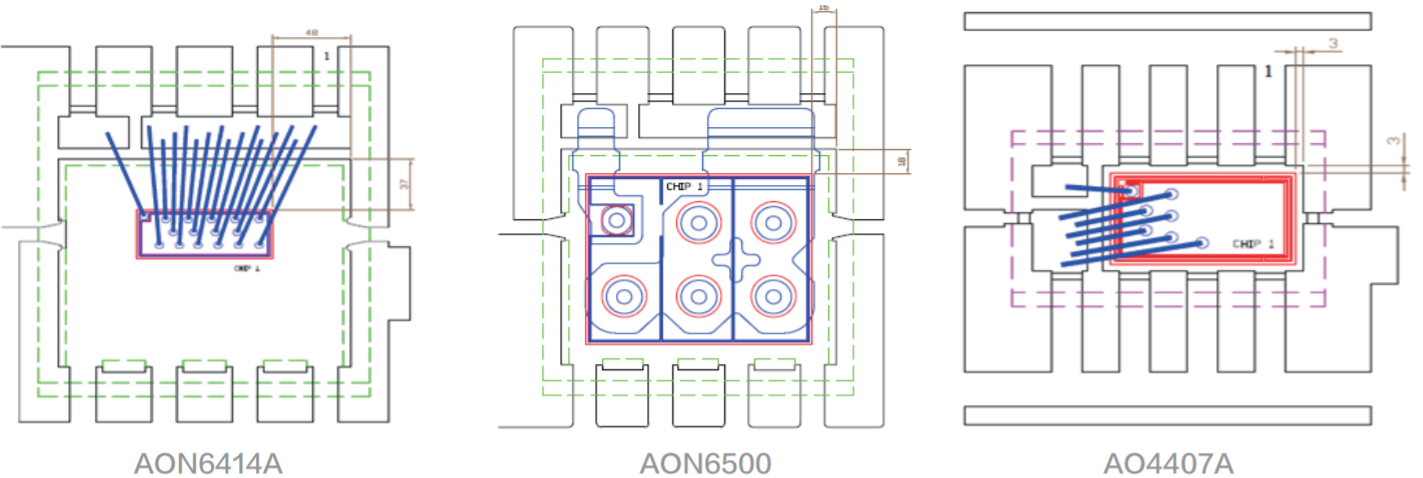

图4 基于弱监督的可迁移学习模型测试准确率图

如图 4 所示,每一代初始模型的测试准确率开始为 56.70%,但在进行了 35 代迁移学习后,模型的准确率提高到 92.5%。而且在 CIFAR-10 数据集的准确率也由最初的 49% 提升到 91.2%。实验证明了一个小的初始数据集可以用来创建一个随着时间推移不断改进和学习的模型。

4 结论

本文的研究表明,在一个相对较小的、初始标记的图像数据集的情况下,可以采用一个改进的弱监督可迁移学习模型,该模型可以通过一些未标记的图像来改进自己,节省初始数据集的训练时间。由于该模型开始时的准确度相对较低,只有在更多的无标签数据集中才能得到改善,因此系统必须能够在模型有时间改善之前处理不合格的标签数据。

参考文献:

[1] 周强.面向图像分类的迁移学习算法研究[D].北京:北京邮电大学,2021.

[2] 魏文怡.基于深度学习的无人机目标识别方法研究[D].南京:南京航空航天大学,2019.

[3] Weiss K,Khoshgoftaar T M,Wang D D.A survey of transfer learning[J].Journal of Big Data,2016,3(1):1-40.

[4] ZHAOR,YANRQ,CHEN Z H,et al.Deep learning and its applications to machine health monitoring[J].Mechani-cal Systems and Signal Processing,2019(115):213-237.

[5] 卜文锐.基于MNIST数据集的参数最优化算法比较研究[J].电子技术与软件工程.2021(11):187-188.

(注:本文转载自《电子产品世界》杂志2022年10月期)

评论