如何一键变身“奥运冠军”?腾讯QQ影像中心告诉你

在刚刚落幕的东京奥运会上,中国体育代表团取得了38枚金牌、32枚银牌、18枚铜牌的优异成绩。这届奥运会期间,除了全民热议运动健儿的精彩表现之外,还有一项神奇的变身特效活动——「我的奥运夺冠时刻」也在全网发酵,引得网民争相试玩和转发。

本文引用地址:http://www.amcfsurvey.com/article/202108/427467.htm在手机QQ的相机功能中,或者天天P图app中,只需上传一张自己的半身照或是全身照,就可以一秒get奥运健儿的同款夺冠时刻,让众多网友大呼“神奇”,“玩得停不下来”。

在这个变身特效视频的背后,是QQ影像中心研发的人体姿态迁移技术。人体姿态迁移技术简单来说,就是给到机器一副含有人物的图片和一个目标姿态,之后经过计算将人物转换为目标姿态的状态。

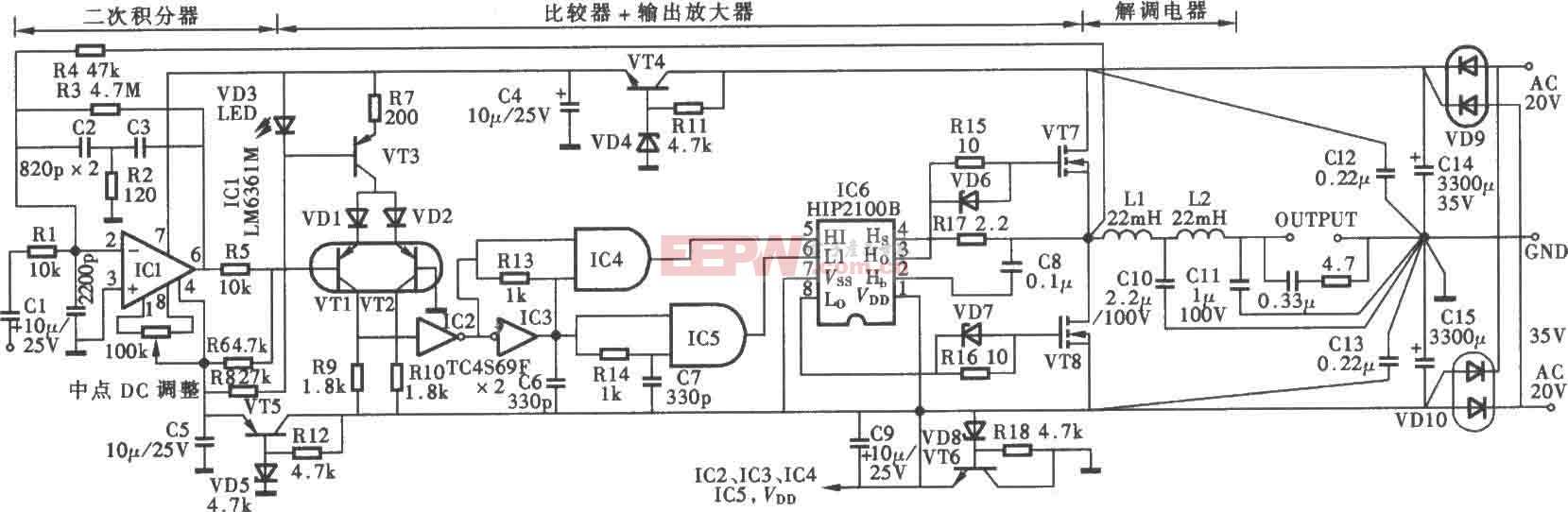

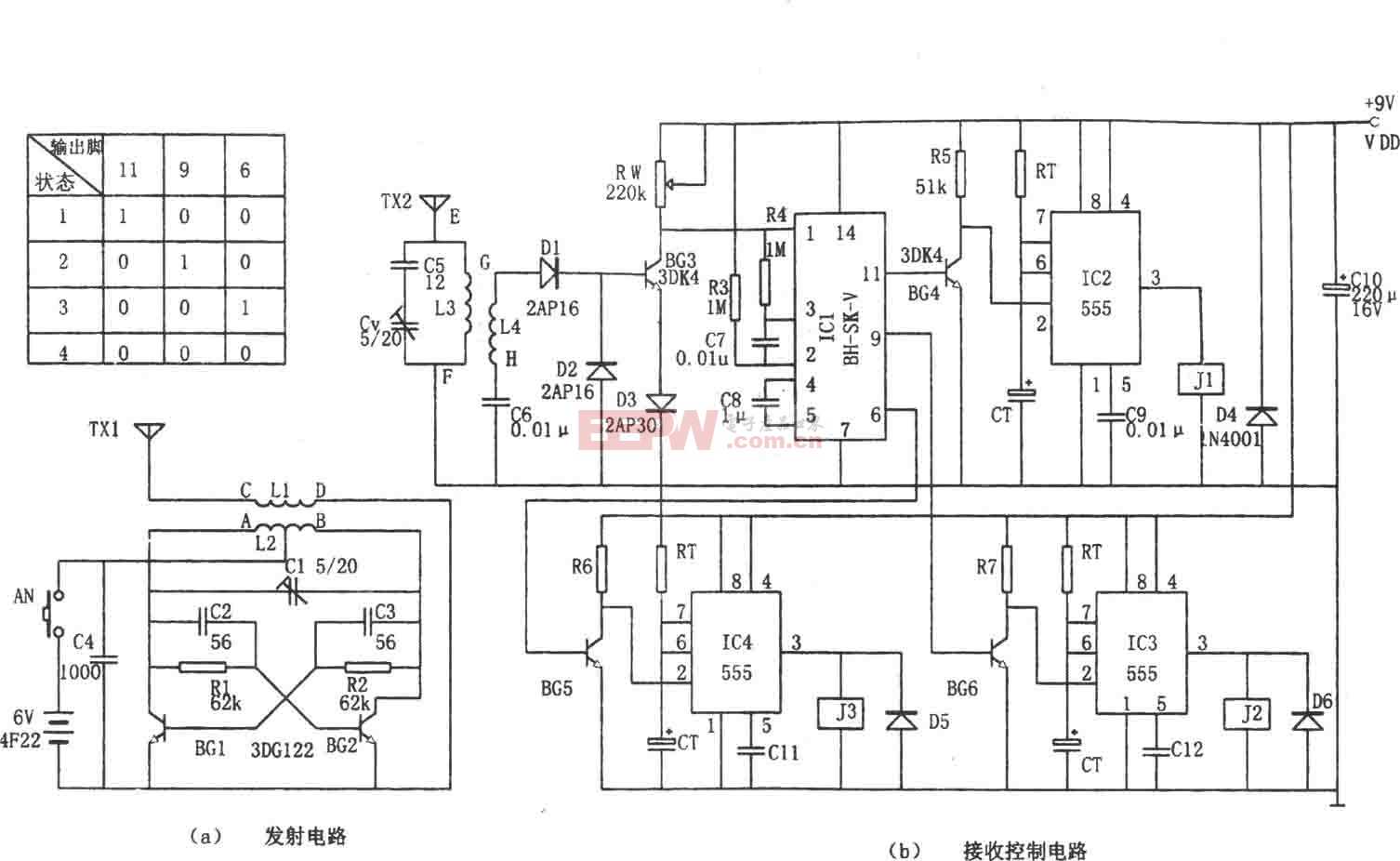

区别于人脸特效功能,围绕人体的GAN生成落地难度较大。在人体动作迁移实现过程中,动作跨度大、像素搬移多、纹理复杂、动作自由度高和自遮挡频繁等干扰因素导致生成指定姿态的人体一直比较困难。目前,主流的人体人体姿态迁移方案有2D warp、3D warp和不依赖warp的解决方案,这三种方式各有利弊,且并未真正落地于实际商业生产应用。

三大技术突破,解锁人体姿态迁移动效新体验

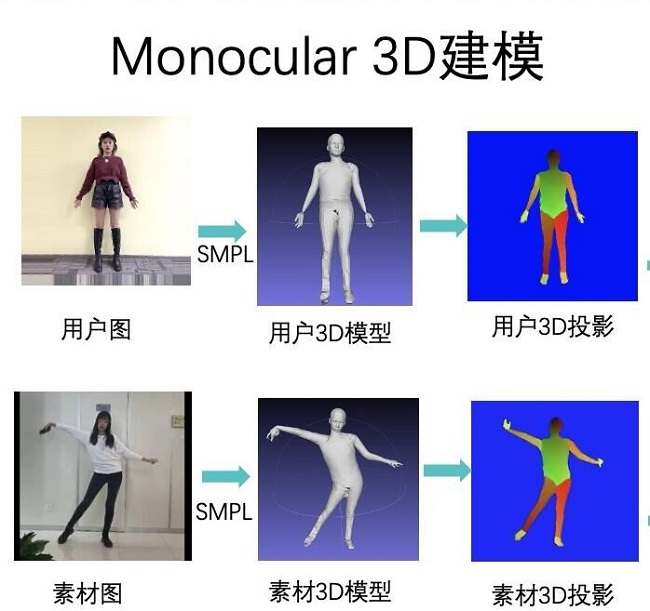

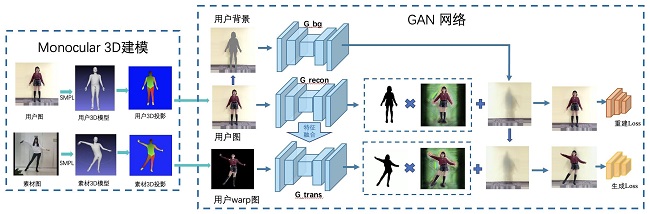

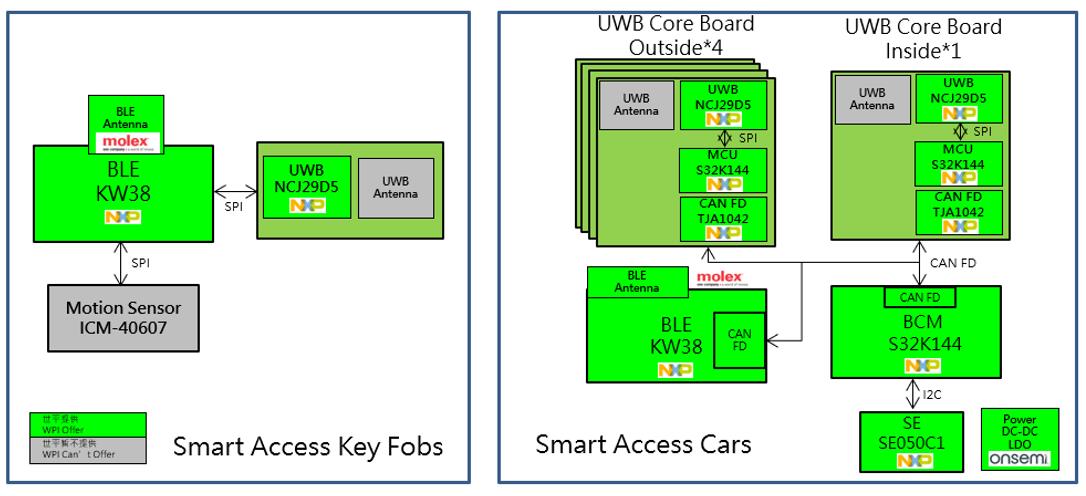

针对现有方案的不足,并考虑在实际应用中,多图或视频输入的姿态迁移方法会使得用户使用门槛很高,带来不太好的用户体验。QQ影像中心团队采用基于单图的3D人体重建结合GAN生成的技术路线。

首先,比起主流方式所需要的视频+在线微调(finetune)模式,QQ影像中心的技术只需要单张用户图就可以完成姿态迁移,并且不需要在线进行模型微调。如此,便能成功将用户的交互难度大大降低。

针对难度极大的3D人体重建,虽然市面上有开源的3D mesh数据库,比如加州伯克利分校的开源端到端框架HMR,但是效果并不理想。所以QQ影像中心团队为此专门研发了一套人体3D重建算法,让整个效果更为流畅连贯。输入单张用户图片,就能得到精确地人体形状和纹理,继而将动态变化的每一帧都转化到参考帧上,再经过计算制作成特效。

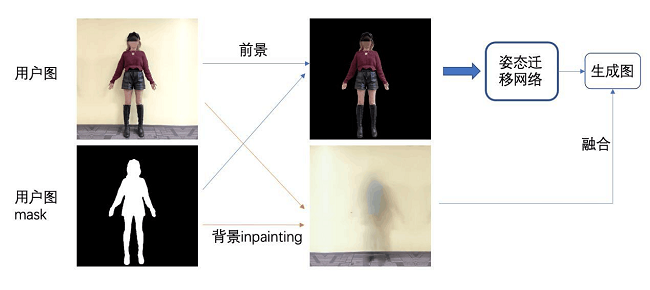

其次,是生成清晰度高,纹理还原度好,支持更高分辨率输出(1024x1024)。比起原先2D warp、3D warp在逼真程度和清晰度上的短板,QQ影像中心算法能够保证其生成质量。其中利用人体分割和背景填充技术,完成目标视频的背景修补。

而针对3D warp图纹理信息粗糙的现象,则利用GAN网络来细化(refine)用户warp图。具体做法是将用户信息与warp图信息在GAN网络中融合,生成自然的目标姿态用户图。在这一步中GAN网络又分为两个子网络,分别是重建网络与姿态生成网络。将用户图重建,之后生成网络输入粗粒度warp图,之后接受重建网络的特征图并进行特征融合,以保证细节信息的准确性,之后特征图将进入解码器,融合前景和特征图,最后得到输出图。

最后,针对基于3D的技术方案容易遇到动作僵硬的问题,QQ影像中心通过平滑策略、2D点辅助优化等策略,既保证了素材的动作准确性,也使动作更加连贯自然。

其实,这次「我的奥运夺冠时刻」变身特效的爆款出圈并非首例。此前,手机 QQ相机功能中内嵌的热门AI玩法——漫画脸,迪士尼童话脸等,同样出自QQ影像中心团队。

从人脸特效到人体动作迁移,QQ影像中心持续探索前沿 AI 和 CV 算法,致力于将前沿的 AI 能力、3D 渲染技术以及先进的玩法赋能产品。团队在语义分割、目标检测、分类识别、GAN生成对抗等方面的深厚技术积累,在AI生成领域已进行了很多相关算法的研发和落地工作。

值得期待的是,未来QQ影像中心也会带来更多特效玩法落地,给用户带来更多有趣的科技体验。

关于腾讯QQ影像中心

腾讯QQ影像中心(原腾讯光影研究室)是腾讯旗下专注于研究前沿影像处理技术的团队,在单目深度估计技术、语义分割、目标检测、分类识别、GAN生成对抗等方面均有深厚的技术积累。团队一直致力于探索泛娱乐综合解决方案,将前沿的AI能力、先进的玩法引擎和3D渲染技术赋能产品,让视觉创意更多样,音视频编辑更智能,社交沟通更趣味。

评论