全景视频为VR/AR带来技术挑战

摘要:VR/AR面临许多巨大挑战,包括Cameras(相机)、环境交互以及网络等,并且这项技术需要软硬件的整体解决方案。

本文引用地址:http://www.amcfsurvey.com/article/201605/291753.htmVR为何忽然变得有意思?

首先,我们看到有一些东西在今天这个时代跨过了门槛,诸如人类历史上第一次可以在一张硬盘上存储一辈子所有听过的音乐,可以存储这辈子所有拍摄过的照片,而且成本非常低廉。慢慢地,我们到达了另一个门口,就是存储这辈子所有看过的视频。其次,每一个人都有一个摄像机,包括手机等便携设备。第三,未来越来越多的人可以无处不在地上网,企业用户和老板可以随时找到你。

我们来想象一下,假如这是媒体实验室在做的事情,它的口号是:Never Lose a memory。将来老师给学生们讲课,不需要描述,可以放给他们看。包括我们给年轻人讲文革、过去的时代,我们可以放给他们看。

VR的三大技术挑战

VR有很多技术的挑战,很多基本技术问题至今没有解决。包括几大核心。第一是Cameras,有大量人做了大量的Camera,但是离我们需要的还有距离。假如你可以控制Camera当中每一个内容,你可以想象做什么东西?第二是需要知道什么地方看什么,如何跟周围环境去交互,包括如何去实现这些技术。当然还包括在移动设备上展现和捕捉全景的视频,即多媒体信息的融合以及多媒体信息的处理和增强。第三是网络,今天网络无处不在,我们设想很多云计算美丽的场景。不过,很多知名的企业把基础设施放在亚马逊上,当亚马逊出现问题的时候怎么办?另外,VR需要大量服务器,这会耗费大量能源,并且需要高速的网络做连接。同时,在VR中做高速的数据处理也有很多挑战。

挑战之一:Camera

在展会上可见各种各样丑八怪的VR原型。假如VR像我们期望的那样变成现实、变成娱乐的主流,VR的主流设备最后一定不是丑八怪。

VR像素会是多少?很多人觉得这不是问题,我们今天可以做2000万、6000万像素的相机。实际上摄像头做得越来越小的时候,像素感光能力越来越弱。另外是艰苦的拍摄环境,比如高动态范围环境以及弱光环境,如何保证高的质量?今天我还没有看到一个相机真正能够模拟电影胶片的水平。

第二个问题是如何保证全景的相机?不同的相机之间或者不同像素以及不同位置如何保持一致性?比如快门是不是同步,曝光能不能做融合,高速运动时是不是会有一些变形等。

第三是我们的相机有没有景深?喜欢摄影的人知道莱卡相机的内容做出来很漂亮,我们能不能提供这些给艺术家?我们认为最终需要把最好的软件和硬件结合起来,而这恰恰是今天没有很多人去做的,我们看到各种各样的全景相机,但是大部分是垃圾。

例如,图1是我们今天看到的VR真实的场景和分辨率。为什么说真实?我们把演员4m以外拍摄的场景放在不同的1K、2K哪怕4K Plus上的分辨率,4m以外看到她的脸和在头盔上显示质量差距过大,相信没有人愿意付费。所以分辨率是非常大的瓶颈。

从技术角度,要真正支持我们所熟知的娱乐界的最低门槛的分辨率。在全景状态,摄像机至少要达到5K×5K,也就是比今天的4K有一个数量级以上的分辨率提高,才可以满足我们最基本的需求。

挑战之二:编/解码

假如我们用今天熟悉的手机分辨率,实际上需要有20K×10K的分辨率,要比今天家里4K的显示器大概有一到两个数量级的提高。这么高的分辨率下如何编码和传输?这是非常大的挑战。因为今天蓝光4K已经用非常高的带宽。

其中一个问题是Encoding(编码)。做技术的人总喜欢做美好的预测,例如今年H.265的编码会全面占领市场,4K的内容会全面占领家庭,但实际上没有这么快。原因首先是系统很复杂。第二系统跟二十年前刚开始做的时候是不一样的。很多人认为可能比上一代提高了50%的效率,但是成本非常高,包括步数、解码器和专利的成本等,有一些甚至需要付出上亿元的成本。即使满足了这些条件,实际上离我们真正做到高质量VR的要求还是有很大的差距。

另外一个问题:有没有什么事情是我们现在可以做的,可以规避这些问题的?答案是有的。我们不是在这里解释技术的细节。业界告诉你或者所谓专家告诉你,做高清一定要H.265,其实不用。用H.264可以达到一样的效果。看到科技公司和清华实验室的编码器得到了美国一家大型市场调查机构编码器领域的大奖,因为我们有很好的H.264的编码器。

要把视频编码真正用到VR上要应用很多场景。比如做360°的视频,用各种巧妙的办法拼接成平面的样子,然后想办法去降低其动态分辨率和成本,用整体上比较低的码率去传输VR的内容。但即使这样,我们离真正的视频编码还有很远的距离。以下会讲我们如何去做这件事情。

主要的思路是:第一我们需要摆脱传统视频编码的做法,过去我们做一个标准需要十年,在中间有很多IP来解决各种各样的问题。现在我们希望做的标准是一个通用的标准,跟应用无关,但是最终的解决方案一定是需要针对VR去做很多优化的。

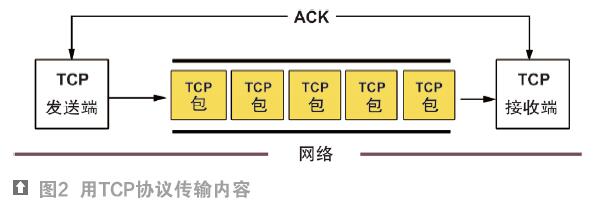

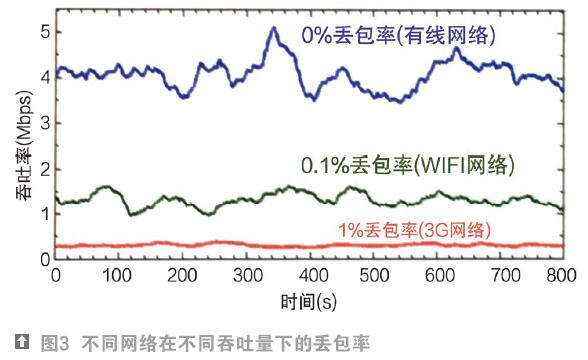

第二个问题是网络。我们有了内容,如何把内容传递给用户。我们有3G、4G等高速网络。但是除了网络基础以外,还有一个问题是如何使用网络。比如90%的是用TCP协议(如图2)。视频当中也多用TCP协议。其实TCP不是一个好的做视频的协议,因为TCP有一个很大的问题:在设计的时候会认为只要你丢包,是因为你发得太快,所以会把发送的速度降慢。实际上,在复杂的无线网络情况下,你用最慢的速度发一样可能会丢包(如图3)。解决办法是设计更好的算法针对你应用的场景。这里我们提出一个算法:TCP-FIT,相比其他算法,TCP-FIT最高可以在相同网络情况下提高7倍的吞吐率,华为和中兴已是我们的客户。

有很多问题是OLDI(Online Data-intensive),比如在淘宝购物或者做大量数据挖掘工作时,做视频编码需要高速的服务器做连接,各层之间延时非常小,才能保证流畅的体验。但有时会突然发现整个网络的吞吐率瞬间降到零,这也是需要解决的问题。针对这些问题,我们也有在不更换设备情况下的解决方案。

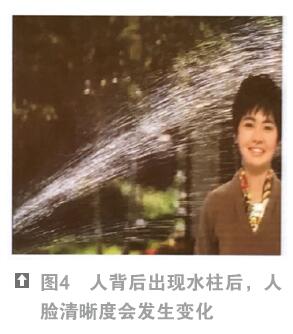

最后强调一点,网络方还需要根据应用对整个系统做优化。例如网上流媒体观看,比如爱奇艺等。通常采用自适应技术,通过带宽不断地推码率,带宽高的时候推得高一点,带宽低时会推得低一些。但是有一个问题,你观看的时候视频质量会变化,例如图4,开始时图4的人脸很清晰,背后突出出现水柱后,会发现人脸的清晰度大幅下降。在中国这种情况不是特别多,因为原本推的就是质量较差的视频流。如何解决这个问题?你可以铺更多CND,可以想办法做编码。但是今天推流的时候你会发现一个很有意思的现象,可能视频是用手机拍的。每个用户手机的拍摄像素不同,因此视频质量不同;另外带宽质量也不同,我们可以用较低的成本大幅度地提高/增强图像精细度。

我们针对应用去重新审视我们系统中的假设。传统的假设是像广电一样,解码器很便宜,编码器很贵,实际应用中可能解码器很贵,编码器很贵。

小结

VR前景很美好,但现实很骨感。到美好的全景视频中间需要解决很多问题。此外,还有怎么做有意思的节目的问题。VR终极的节目是不是游戏?不一定。

技术上,第一,今天的质量原因是你需要容纳全景信息。第二,我们需要系统化的解决方案,未来的VR未必是做很便宜的全景相机的一帮人,然后把内容放到现在大家知道的视频平台上,用标准的模具生产的眼镜或者其他装置去观看。未来一定有一个端到端想清楚的解决方案,从拍摄到编码、传输、存储,一定是系统的。第三是我们需要重新审视原来做各个技术的认为习以为常的假设,这些假设是不是适合我们应用的环境,比如编码、推送和消费,只有整体的推进才能带来数量级的性能提升。所以VR的用户体验是从多维度来衡量的,比如质量、延时等等,需要软件和硬件工程师一起来提出一个整体的解决方案,硬件和软件协同做优化。

最后是需要艺术家和技术专家更好的融合做事情,在VR这里面会有一个非常明显的展现。(注:改编自“2016全球VR/AR趋势论坛”上的讲演。此论坛由IDG主办,2016年4月20日,深圳CE China展览期间举行)

本文来源于中国科技期刊《电子产品世界》2016年第5期第12页,欢迎您写论文时引用,并注明出处。

评论